撰文 / 涂彦平

编辑 / 黄大路

设计 / 赵永顺

2023年5月,马斯克透露特斯拉FSD V12将采用端到端方案。2024年3月,特斯拉开始大范围推送V12。

根据第三方网站FSD Tracker的统计,特斯拉FSD V12更新后,较之此前版本,用户完全无接管的行程次数占比从47%提升到72%,平均接管里程(MPI)从116英里提高到333英里。

在特斯拉FSD V12上,端到端自动驾驶技术显示了强大的实力。

随着AI和大模型技术的发展进入全新阶段,端到端技术成为自动驾驶行业关注的焦点。那么,什么是端到端?它的技术演进到了什么程度?

2024年6月,辰韬资本、南京大学上海校友会自动驾驶分会、九章智驾三方联合发布2024年度《端到端自动驾驶行业研究报告》(以下简称《报告》),从端到端自动驾驶的基本概念、参与者、发展驱动力、落地挑战和未来展望进行全方位的分析。

端到端是什么

《报告》对端到端自动驾驶技术做了一个系统性的概念梳理,并提出一套可供参考的术语体系,对端到端的基本概念进行了界定。

《报告》指出:早期,端到端的核心定义是“从传感器输入到控制输出的单一神经网络模型”,近年来,端到端的概念有了更大范围的延展。《报告》认为,端到端的核心定义标准应为:感知信息无损传递、可以实现自动驾驶系统的全局优化。

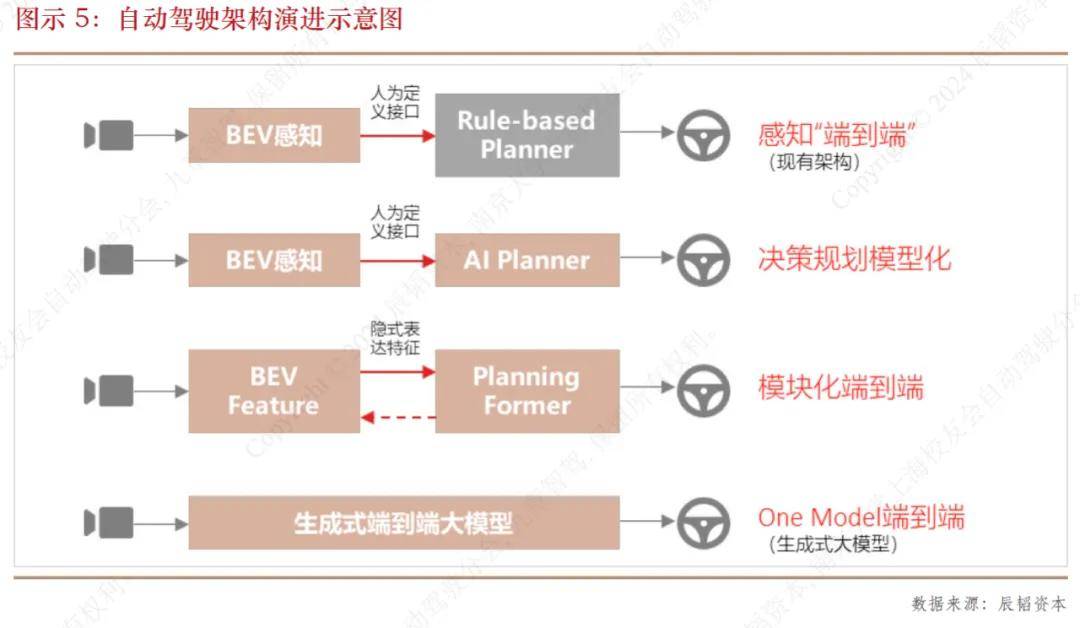

基于这个定义,结合自动驾驶系统中AI的应用程度,《报告》将自动驾驶技术架构分为四个阶段:

第一阶段:感知“端到端”。感知模块通过基于多传输器融合的BEV (Bird Eye View,鸟瞰图视角融合) 技术实现了模块级别的“端到端”。

第二阶段:决策规划模型化。从预测到决策到规划的功能模块已经被集成到同一个神经网络当中。

第三阶段:模块化端到端。感知模块不再输出基于人类理解定义的结果,而更多给出的是特征向量。预测决策规划模块的综合模型基于特征向量输出运动规划的结果。两个模块无法独立进行训练,必须通过梯度传导的方式同时进行。

第四阶段:One Model端到端。不再有感知、决策规划等功能的明确划分,从原始信号输入到最终规划轨迹的输出直接采用同一个深度学习模型。

其中,后两个阶段符合前述端到端的定义标准。

此外,报告也对端到端与大模型、世界模型、纯视觉传感器方案等易混淆概念的区别与联系作了辨析。

各路玩家

2016年4月,英伟达团队发表了一篇名为End to End Learning for Self-Driving Cars的论文,展示了基于卷积神经网络(Convolutional Neural Network, CNN)的端到端自动驾驶系统DAVE-2。

该系统通过CNN处理车辆前方的摄像头图像,并直接输出转向角度。训练过程中,模型通过模拟驾驶数据进行学习。《报告》称其是近年来端到端自动驾驶领域的开创性工作。

当前市场上,端到端自动驾驶的玩家有很多,《报告》将其分为几类:

其一,主机厂。如特斯拉、小鹏汽车、鸿蒙智行、蔚来、零一等。

2024 年5 月20 日,小鹏汽车举办AI Day 发布会,宣布端到端大模型上车。

2024年4月24日,华为推出智能驾驶系统新版本——乾崑ADS 3.0,实现了决策规划的模型化,为端到端架构的持续演进奠定了基础。

此外,蔚来计划2024 年上半年上线基于端到端的主动安全功能,新能源重卡科技公司零一汽车计划2024 年底实现端到端自动驾驶的部署上车。

其二,自动驾驶算法和系统公司。如元戎启行、鉴智机器人、商汤绝影、小马智行等。

地平线2022年提出自动驾驶感知端到端算法Sparse4D;2023年,由地平线学者一作发表的业界首个公开发表的端到端自动驾驶大模型UniAD,荣获CVPR 2023 最佳论文。

2023年8 月,小马智行将感知、预测、规控三大传统模块打通,统一成端到端自动驾驶模型,目前已同步搭载到L4自动驾驶出租车和L2辅助驾驶乘用车。

2024 北京车展前夕,英伟达透露了自动驾驶业务的发展规划,提到规划的第二步为“在L2++系统上达成新突破,LLM(大语言模型)和VLM(视觉语言模型)大模型上车,实现端到端的自动驾驶”。

2024年4月北京车展上,元戎启行展示了即将量产的高阶智驾平台DeepRoute IO以及基于DeepRoute IO的端到端解决方案;商汤绝影推出面向量产的端到端自动驾驶解决方案“UniAD”以及下一代自动驾驶技术DriveAGI,前者属于“模块化端到端”类型,后者为“One Model端到端”。

2024北京车展期间,鉴智机器人联合创始人、CTO 都大龙透露,鉴智机器人原创的自动驾驶端到端模型GraphAD已经可量产部署,正与头部车企进行联合开发。

其三,自动驾驶生成式AI公司,如光轮智能、光轮智能等。

2023年初成立的光轮智能,目前已经开发了自研的端到端数据与仿真的全链路解决方案;光轮智能2023年9月推出自动驾驶世界模型DriveDreamer,可以实现端到端自动驾驶的全链路闭环仿真,可以扩展实现直接输出端到端的动作指令。

其四,学术研究机构,如上海人工智能实验室、清华大学MARS Lab等。

诸多挑战

2023年以来,在特斯拉的标杆作用、大模型代表的AGI技术范式以及自动驾驶拟人化和安全性需求的共同推动下,自动驾驶行业对端到端的关注度一路升温,端到端已逐渐成为自动驾驶行业的共识。

《报告》对30余位自动驾驶行业一线专家的调研显示,90%被调研者表示自己供职的公司已投入研发端到端技术。

《报告》分析了端到端方案落地面临的挑战,包括技术路线、数据和算力需求、测试验证、组织资源投入等。

其一,技术路线的分歧。

比如,“模块化端到端”采用监督学习的训练范式,“One Model 端到端”可能更加侧重自回归和生成式的训练范式,两种路线都有公司押注。《报告》判断,未来1~2 年内,随着更多公司和研究机构在端到端领域加大投入并推出产品而逐渐明晰,技术路线将会逐渐收敛。

其二,对训练数据的需求量空前提升。

在端到端技术架构下,训练数据的重要性得到前所未有的提升,其中,数据量、数据标注、数据质量和数据分布的相关问题都可能成为限制端到端应用的挑战。《报告》提出,合成数据、建立数据共享平台可能是解决之道。

其三,对训练算力的需求越来越高。

大部分公司表示100张大算力GPU可以支持一次端到端模型的训练。而端到端进入量产阶段,训练算力需求急剧提升。

在2024Q1财报电话会上,特斯拉表示已经有35000张H100GPU,并计划在2024年内增加到85000张H100以上。此前,它还部署了规模更大的A100 GPU训练集群。

小鹏2023年8月宣布建成“扶摇”自动驾驶智算中心,算力可达600PFLOPS(以英伟达A100 GPU 的FP32 算力推算,约等于3 万张A100 GPU)。

另外,商汤大装置已经布局全国一体化的智算网络,拥有4.5万块GPU,总体算力规模达12000PFLOPS,2024年底将达到18000PFLOPS。

《报告》提出,“大部分研发端到端自动驾驶的公司目前的训练算力规模在千卡级别,随着端到端逐渐走向大模型,训练算力将显得捉襟见肘。”

其四,测试验证方法尚不成熟。

现有测试验证方法不适用于端到端自动驾驶,行业亟需新的测试验证方法论和工具链。

其五,组织资源投入的挑战。

端到端需要组织架构重塑,也需要将资源投入倾斜到数据侧,对现有模式提出挑战。

此外,有观点认为车端算力不足和可解释性问题是端到端落地的限制因素,《报告》提出了相反的结论。

展望:2025年量产上车

《报告》展望,国内自动驾驶公司的模块化端到端方案上车量产时间可能会在2025年,One Model端到端落地时间会晚于模块化端到端1~2年时间,从2026年至2027年开始上车量产。

这将带动上游技术进步、市场和产业格局演变。

在技术上,端到端的落地会推动其依赖的上游工具链、芯片等加速进步;在市场端,端到端带来的自动驾驶体验提升,将会带来高阶辅助驾驶渗透率的提升,也可能驱动自动驾驶跨地理区域、跨国家、跨场景的应用;产业格局方面,端到端使数据和AI人才的重要性进一步提升,可能催生新的产业分工和商业模式。

自动驾驶在发展早期借鉴了很多机器人行业在感知算法、规划算法、中间件和传感器等多个层面的积累。而近年来,自动驾驶技术和产业成熟度提高,其中端到端自动驾驶提供的AGI技术范式,对通用人形机器人产业具有反哺作用。

《报告》认为,随着AI技术的不断进步,自动驾驶和机器人技术的相互融合、相互借鉴将更加深入,共同推动AGI(通用人工智能)走向物理世界,创造更大社会价值。

推荐

夏季出游购车首选欧拉闪电猫,B级纯电轿跑陪你嗨翻欧洲杯

车讯视野

【韩系动向1295】现代和比亚迪或将在欧洲打响价格战!

郑谊

国民家轿 一步到位, 朗逸2024款限时8.38万起

汽车葫芦圈

车动态:全新宝马M5量产;奇瑞半年销量破百万

车动态

家用SUV三国杀,零跑全新C11、深蓝S7和宋PLUS DM-i ,该选谁?

车载娱乐

国民家轿 一步到位,朗逸2024款限时8.38万起

汽湃上汽大众低调入局,新一轮价格战正在酝酿?

车壹圈

20万内大空间轿跑,小鹏MONA M03全球首秀

车载娱乐

新卡罗拉上市增配价更优,官方限时权益至高2.4万元、

行车探秘空间超理想MEGA,34.99万起,这款MPV能火吗?

汽车洋葱圈

铃木海外热卖SUV,哪哪都好就是国内买不到

UCAR汽车网站

凭啥月销超2万辆?深挖零跑成功背后的商业逻辑!

郑谊评论

暂无评论,抢占沙发