以激光雷达为代表的雷视融合方案和纯视觉路线的谁优谁劣伴随着智驾从手写规则到今天的端到端阶段,不过如果抛弃算力、算法和大模型能力来单纯对比激光雷达和纯视觉的优劣显然是舍本逐末。在AEB即将成为国标之际,目前的标准要求也远未到激光雷达与纯视觉只能二选一的地步。

文丨智驾网 July

编辑|雨来

一纸新规,再次将AEB话题引入舆论场。

5月,工业和信息化部发布《轻型汽车自动紧急制动系统技术要求及试验方法》(征求意见稿),将自动紧急制动系统(AEB)从推荐性标准升级为强制性国家标准,并计划于2026年起分阶段实施。该标准将替代现行国标GB/T 39901-2021,征求意见截止日期即将在本月底(6月30日)结束。

这是目前智驾辅助功能中第一次上升为国家强制标准,但它同时也引发了技术路线的争议,如果强制安装AEB是否意味着所有的车型都需要标配激光雷达?

智驾网梳理了新国标三大核心变化——

适用范围扩大:要求所有M1类乘用车(轿车、SUV、MPV等)和N1类轻型载货汽车(总质量≤3.5吨)强制装备AEB系统,覆盖中国90%以上轻型车辆;

技术要求升级:新增对行人、自行车、踏板式两轮摩托车等弱势道路使用者的识别能力要求,并增加交叉路口、右转跟车等复杂场景测试;

性能指标提升:乘用车AEB激活范围扩大至10-80km/h,制动减速度要求从4.0m/s²提高到5.0m/s²,针对静止前车的测试速度从30km/h提高到80km/h;

但在这些变化之中,值得注意的是,新国标并未强制要求安装特定的传感器配置,其性能导向的特性也为多元技术路线留下了充分可讨论的空间。

01.

AEB争议为何再起?

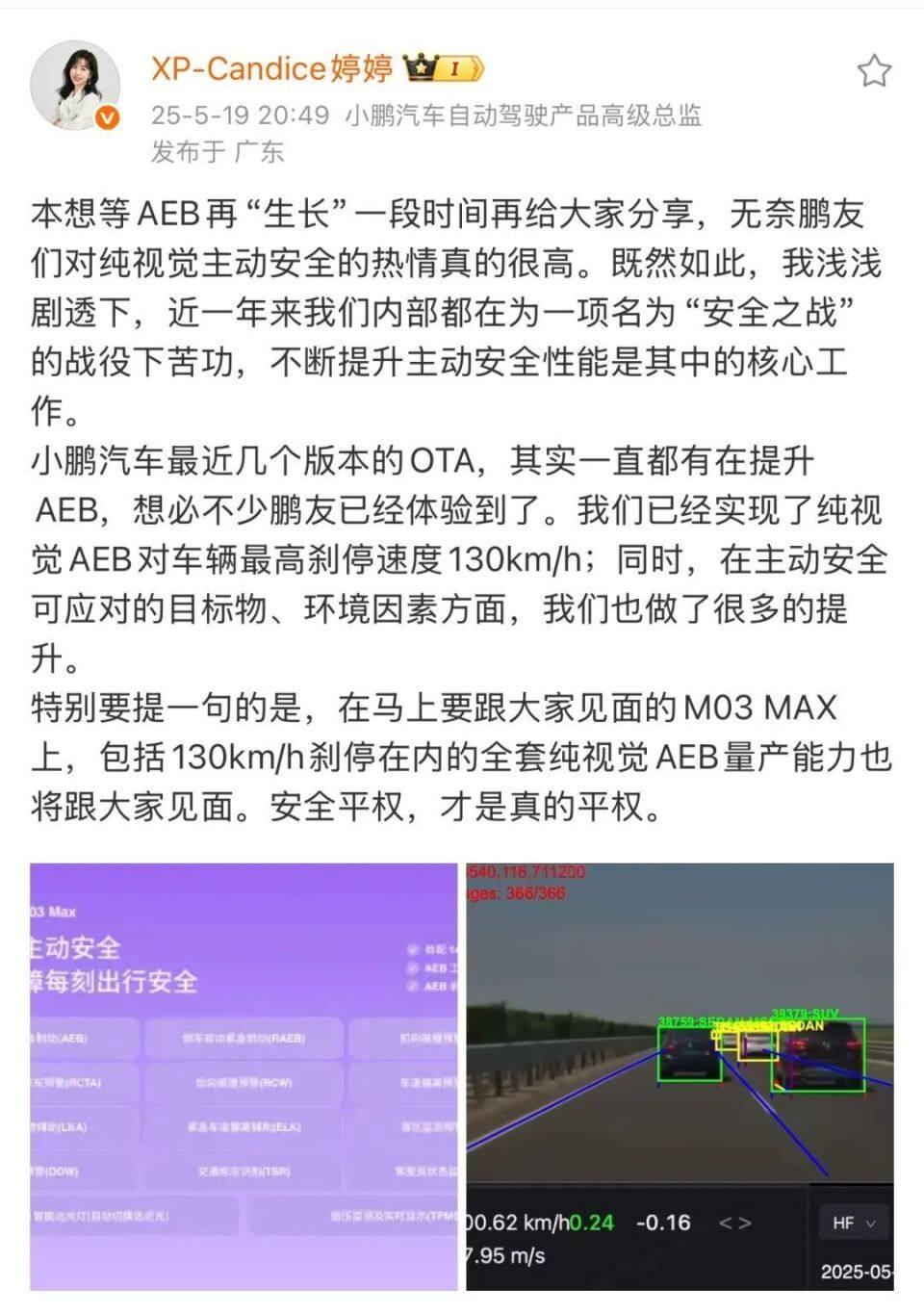

AEB的技术路线目前有毫米波雷达、纯视觉和雷视融合三种。

当前众多车辆的AEB系统基于77GHz毫米波雷达实现,在三种技术方案中,依靠毫米波雷达的这一方案,是最基础的技术方案,同时成本最低,应用广泛,但缺点是易受环境干扰,极易失效。

纯视觉方案,依赖摄像头进行感知,这种方案的弊端在于对静止物体的识别存在局限性,也容易受到光线等环境干扰。

目前声势最盛的是多传感器融合方案,毫米波雷达、激光雷达和摄像头融合使用,弱点是成本更高。

不过当下所说的纯视觉方案其实也是摄像头和毫米波的组合方案。

直观来看,多传感器雷视融合方案最佳,虽然成本相对更高,但AEB做为紧急状态下的最后一道屏障,与安全相比,成本高一些无可厚非。

不过,不考虑算力、算法,单纯对比传感器多寡,一刀切地认为拥有激光雷达就一定强于纯视觉则有失偏颇。

在新国标发布之际,行业也正经历一场关于AEB技术路线的激烈争论。

激光雷达派:

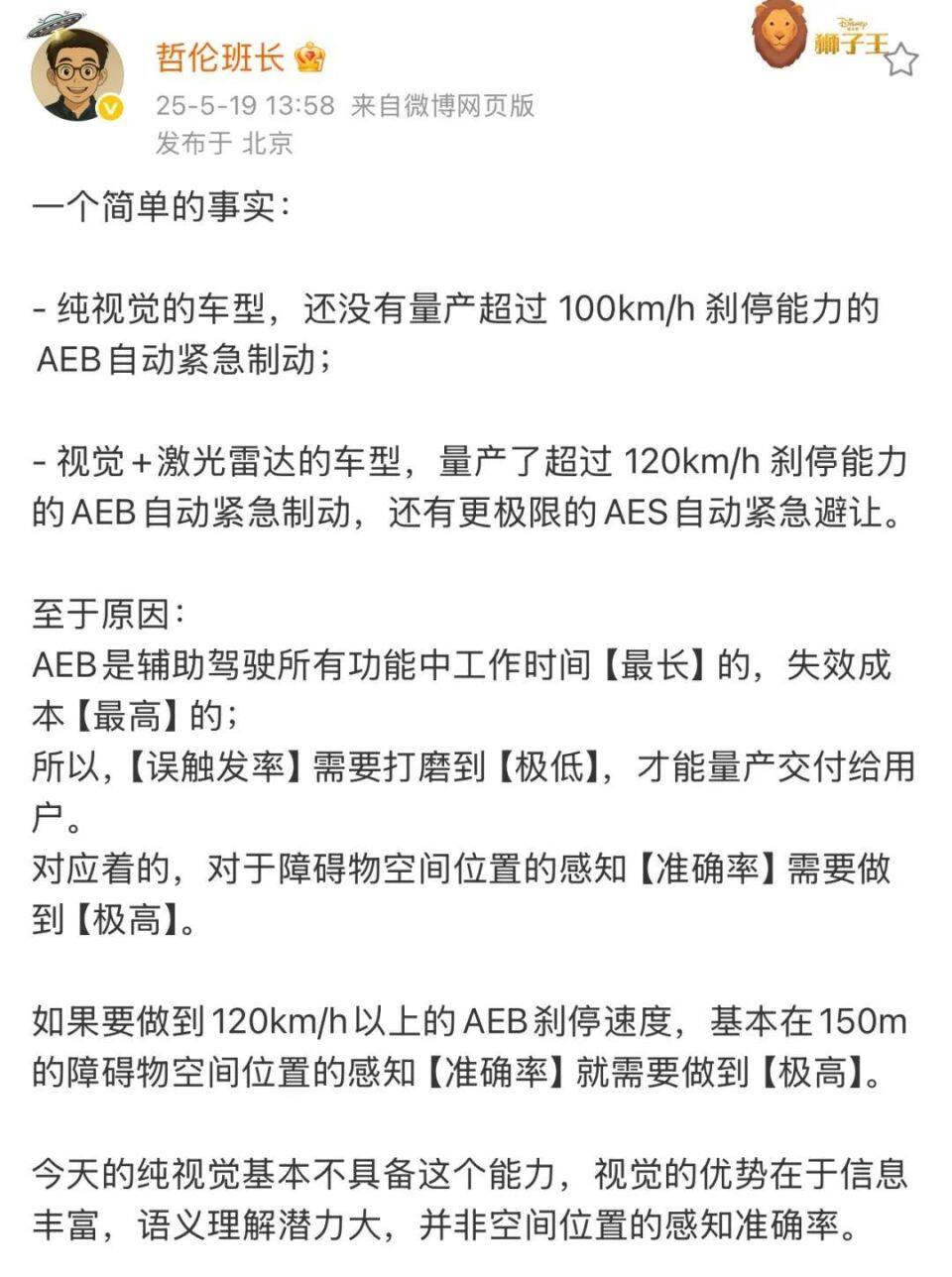

有博主在社交媒体发文称,纯视觉方案尚未实现100km/h以上刹停能力,而融合激光雷达的方案已量产120km/h刹停能力。

他强调:“对静止车辆的空间感知需要150米的精准测距”。

言下之意,纯视觉无法实现150米距离的精准测距和识别。

视觉方案派:

小鹏汽车自动驾驶产品高级总监袁婷婷则表示小鹏汽车的纯视觉方案已实现了130km/h动态车辆刹停,上市的小鹏M03 MAX将搭载该技术。

从两方在社交媒体的争论不难看出,核心聚焦在纯视觉方案能否在更高时速(120公里时速)实现对相对安全距离(150米)的目标的精准识别。

在这场争论之后不久,6月19日,小鹏汽车发布测试视频并宣称其纯视觉AEB实现130公里/小时对静止目标刹停(行业最高速),并覆盖夜间、湿滑路面等复杂场景,小鹏汽车表示其纯视觉路线凭借「大模型+高算力」可实现更低延迟(40ms)和更强泛化能力。该功能预计在本月底全量推送。

而此前行业高速AEB性能的标杆普遍在100-120km/h(激光雷达方案上限),华为和理想对外展示的最高时速上都达到过130公里,小鹏通过纯视觉实现130km/h刹停,追平了主流的雷视融合方案(当然有观点认为AEB的刹停时速也不宜过高,会对人体造成伤害)。

通常,激光雷达方案的延迟在80ms以上,40ms端到端响应速度则更具低延迟优势,源于省去多传感器数据融合的算力消耗,提升了决策效率。

袁婷婷表示,激光雷达远距离信息稀疏且易受天气干扰,而高分辨率摄像头+AI模型才是更优解。

当AEB的话题被重新推至风口,这一次纯视觉想要打翻身仗,小鹏势必要解决一些更难的问题。

02.

AEB最核心的感知难题,纯视觉怎么解?

近来发生的多起智驾事故中,AEB不起作用被广为诟病,这其实涉及一个两难问题:

太敏感,会造成不断刹停,严重干扰驾驶者的正常行驶;

降低敏感度,又起不到自动驾驶保障安全的目的,而当前无论摄像头还是毫米波雷达、激光雷达,都无法做到对障碍物的百分百识别,这也是当前AEB的核心难点。

在工作原理上,AEB的激活需要经过感知、决策、执行三个步骤。首先系统要通过雷达、摄像头等感知硬件监测前方的道路环境信息,识别障碍物。如果存在障碍,系统将会基于车辆与障碍之间的距离,或碰撞所需时间来评估碰撞风险,如果判定系统设定的某个安全阈值时,便会触发紧急制动。

事实上,AEB是各大自动驾驶团队最难攻克的技术,原因是太难平衡。

AEB作为一个刹车机制,自身带有感知算法,不同物体对探测的反应是不是一样的,它的准确运作聚焦于四个方面:识别的准确率、感知延时、控制精度和控制的延时。

AEB表现的好坏即依赖于传感器、算法等智驾技术能力,也依赖于车辆刹车等硬件的物理能力。

当下的技术能力,视觉路线已相比激光雷达有了巨大的优势。

这一方是摄像头的像素越来越高,800万像素的摄像头越来越普遍,看得更清;一方面,视觉算法开始替代毫米波雷达承担AEB的识别触发机制,视觉算法相比毫米波雷达造成误触发的概率开始大幅下降。

只不过这一技术路线一来对算力要求很大,同时受光线影响较大。

坚持纯视觉智驾技术路线的小鹏给出了解法,即加大车端算力和通过大模型强化学习。

小鹏在日前预售的G7车型Ultra版算力做到了2200TOPS,这款车型搭载了小鹏自研的3颗图灵AI芯片,算力相当于9颗当前主流的智驾芯⽚(Orin X) 。

算力可以被比喻为智驾发展的「燃料」,大模型是「引擎」,视觉感知则是「第一性原理」,三者结合推动感知系统从「看见」升维至「理解」,最终实现人类级场景认知。

何小鹏给过的预判是,2026-2027年「世界模型+强化学习」将推动L4级智驾落地,而视觉感知作为基础层,其可靠性决定终极体验上限。

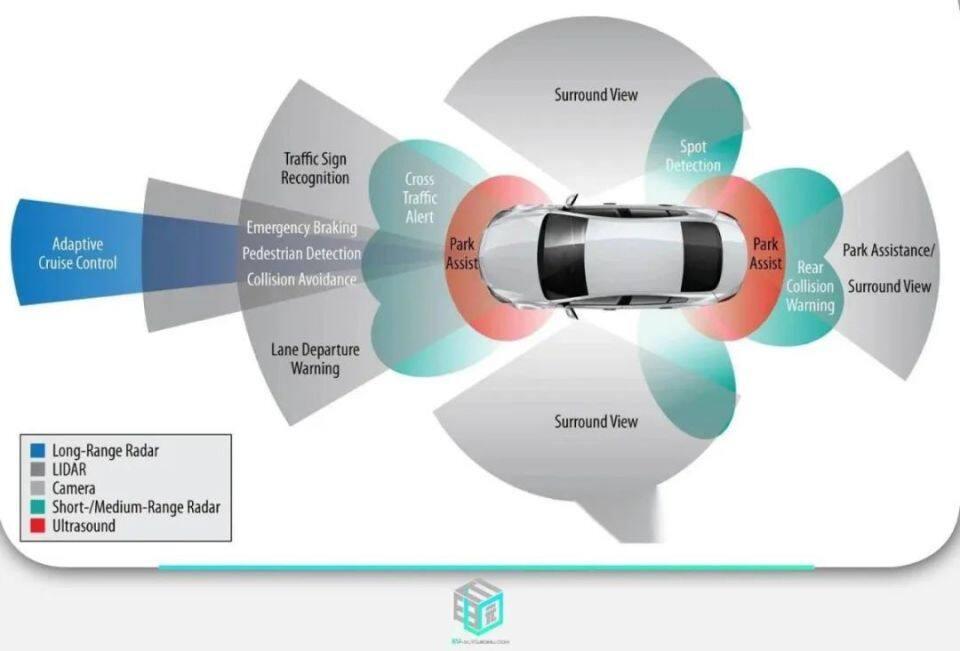

现在,小鹏汽车已对外宣布正在研发参数规模达到720亿的云端大模型,即“小鹏世界基座模型”。

该基座模型是以大语言模型为骨干,使用海量优质驾驶数据训练的VLA大模型(视觉-语言-行为大模型),具备视觉理解能力、链式推理能力(CoT)和动作生成能力。

依靠「高算力+强模型」,能增强主动安全的可靠性,强大的模型能够提升感知信息的处理效率和精度,高算力能够让大模型在车上跑得更顺畅。

在大算力和大模型的共同赋能下,视觉感知能将原本规则时代的单帧图片识别,转化为4D动态信息,能够推理前后帧之间的因果关系,判断在道路行驶中后续可能发生的情况。

同时只有视觉感知能做到前融合的方案,将时延降到最低。在夜间、雨雾等场景,大模型下的视觉融合方案都会更安全。

如果算力充足,那么用一段式端到端方法做AEB一定是最佳选择,从感知到决策再到规划控制,可以一步到位。

而当有了更雪亮的眼睛(更准确的识别感知),更聪明的大脑(更快瞬时推理能力),就会造就更敏捷的身手(更快响应速度),最终造就更强大、更好用的AEB。

如果给何小鹏出一道选择题,是一双更聪明的眼睛重要,还是一个更强大的大脑更重要,他会说,小鹏选择后者。

为了搭建云端足够大的模型,小鹏训练了数百亿参数规模的云端基座大模型,参数量达车端模型的80倍,这意味80倍参数可以吸纳corner case,突破规则代码上限。

所以,如果小鹏的云端数据规模真能达到官方所说的「720亿参数量」和「集群算力10EFLOPS」,那么的确是世界TOP级别的规模与投入。

现在,小鹏云端大模型参数量达车端模型的80倍,这意味80倍参数可以吸纳corner case,突破规则代码上限。

而在云端训练超大模型的基础上,小鹏并非简单将云端基座大模型直接部署到车端,而是通过知识蒸馏(Knowledge Distillation)实现“大模型智能下沉”,在保障安全性与实时性的同时突破车端算力限制。

蒸馏可以理解为将“教授知识”压缩至“学生模型”。

在驾驶真实场景中,直接训练小模型容易因驾驶场景多解性(同一场景有多种合法路径)导致模型混淆,而大模型通过统一模态蒸馏可避免此问题。

另一个技术优势是有望突破Scaling Law边际效应。

小鹏指出,无论是自己2000万clips的云端数据量,还是其他家的xx千万,都是建立在“视频切片”的基础上。

云端大模型在充分吸收海量数据后,蒸馏后的小模型性能就会远超同参数直接训练的模型上限。

虽然硬件双冗余对于感知硬件的一项要求就是要配备激光雷达,但现在以纯视觉智驾技术路线为代表的小鹏拥有长期规模投入的能力,通过更强大的大脑替代激光雷达的物理感知冗余,在主动安全领域实现了对激光雷达融合感知路线的系统性突破。

03.

纯视觉AEB比雷视融合更具未来性

倘若视觉感知实现真正的前融合,系统时延就会降到最低,从长期来看,纯视觉是解决感知上限的最优解。

6月16日,特斯拉副总裁陶琳在微博上发布了一则马斯克的采访视频,马斯克在采访中表示,与道路系统最适配的智能驾驶技术就是人工智能、数字神经网络和摄像头相结合。

「当然我们的车辆还配备了麦克风,用于识别紧急车辆的声音」。马斯克认为,全世界的道路系统都是为了智能、生物神经网络和眼睛设计的,而不是根据「从眼睛里发射激光」来设计的。

纯视觉感知究竟解决了雷视融合感知路线的哪些问题?

最核心的是解决了延迟和误检的问题。

比如,激光雷达是点云数据,数据量大且频率低,给整体的系统延时带来了较大负担。激光雷达在大雨/雾天场景容易出现误检,比如镜面反射、点云膨胀等。

相比激光雷达的点云数据,摄像头是图像/视频数据,两种不同模态的信息在车端融合,一方面需要较高的存储和处理成本,对于需要在毫秒之间作出响应的辅助驾驶系统来说,由此导致的任何延迟都不可接受;另一方面,不同模态的信息如果相互矛盾,会影响AI大脑的决策。

采用统一的视觉模态信息,会让系统响应效率更高,提升驾驶安全性。

当然,激光雷达的优势是可以实现对障碍物物体空间位置的感知,以及对于强逆光、雨雾的穿透,以便做到较低的误触发率,纯视觉如何做到或者超过激视融合感知路线的准确率和低误触发率?

小鹏汽车产品经理Mike给出的解释是,降低误触发的核心是对道路情况看得清、看得远、看得准。

他以小鹏鹰眼视觉+毫米波雷达方案举例,这套方案能做到对障碍物空间位置的感知,尽量减少误识别。再加上一个足够聪明的大脑,就能对道路上的突发状况做快速的推理分析,准确评判风险,而不是动辄刹车了事。

熟悉小鹏的人都知道,小鹏是第一家量产激光雷达车型的车企,也是第一家把激光雷达去掉的车企。

Mike说,小鹏在去掉激光雷达后,节约了20%的感知算力,这样可以升级视觉感知模型的容量、参数量和推理的频率。

有专家表示,激光雷达最高每秒10帧,而视觉摄像头可以实现24帧,激光雷达的10Hz是主动扫描式采样,视觉的24Hz是被动并行式采样,后者在时间分辨率上具有物理层优势。

高帧率视觉的核心价值在于构建时空连续性的认知能力——当激光雷达还在「逐帧拼凑世界」时,视觉系统已在「理解运动故事线」。这恰恰是应对国内复杂城市场景(鬼探头、加塞等)的最优解,亦是传感器频率差异的本质意义。

从短期成本可控来看,如果想省掉钻研算力算法的苦力活 ,中高算力+激光雷达的确是个好选择,随着激光雷达上车,与视觉算法结合,理论上当然效果更好,但是实现二者的数据融合又是另一个技术门槛。

很难说实现二者数据融合的门槛不比纯视觉更高。

在智驾网近年来采访的多位智驾专家中,一致的观点纯视觉是智驾的未来。

但鉴于近期的诸多智驾事故,部分人将事故的原因归结于硬件配置的不足,回避了自身算法能力的不足,反而给大众形成了激光雷达是不可缺少的智驾配置的认知。

何小鹏说“2027年以后,纯视觉技术不会再有分歧。”

为什么是2027年?因为彼时大抵市场上的玩家都基本解决了算力和模型问题。

end.

推荐

两个多月后,新能源车也要缴纳购置税,合资燃油车熬到头了?

车快评体验再进阶! 问界M9 2024款华为ADS小蓝灯升级开启预约

驾域AUTO

主打听劝!问界M9 2024款华为ADS小蓝灯升级开启预约

Car路里

【快讯】官方公布阿维塔06调查结果|已排除动力电池起火

车动力

刘强东同款,售价128万元仰望U8L国庆狂揽600单

车壹条

Model 2“跳票”五年,特斯拉减配上新:又割韭菜?

车壹条

国庆PHEV纯电出行550公里,续航打5折充电4次,下次再也不试了!

DearAuto

全新一代岚图梦想家:一场高端MPV的价值革命

买车网固态电池刷屏!电动车的“救星”终于来了?别高兴太早

DearAuto

0首付 长安马自达新能源全系车型十月限时钜惠

宇尘说车

不卷价格卷价值,路虎在中国走出“小众”活法

道哥说车

同环比双增创年度新高!九月荣威、MG零售突破9.7万辆

宇尘说车评论

暂无评论,抢占沙发